Grundbegriffe des Empirismus

Was immer der Positivismus gegen die Metaphysik vorbringen mag, ist sinnlos.

Was immer die Metaphysik zur Selbstverteidigung gegen den Positivismus vorbringen mag, ist falsch

Wolfgang Stegmüller (1954)

Dem Wissenschaftler geht es in der herkömmlichen Forschung darum, Beziehungen zwischen Ursache und Wirkung aufzudecken, die zum Verständnis der von ihm beobachteten Phänomene beitragen. Wissenschaft ist daher jede intersubjektiv überprüfbare Untersuchung von Tatbeständen und die auf ihr beruhende, systematische Beschreibung und Erklärung der untersuchten Tatbestände. Eine Wissenschaft besteht traditionell demnach aus

- Theorie: Beschreibungen, Modelle, Erklärungen,

- Empirie: Tatsachen, Beobachtungen und

- Kommunikation: intersubjektive Überprüfung

Dabei lassen sich zwei "Typen" von Wissenschaftlern bzw. zwei Vorgangsweisen unterscheiden:

Der Empiriker argumentiert, dass man nur genügend Einzelbeobachtungen zusammentragen muß, um das komplexe Beziehungsgefüge zwischen diesen isolierten Informationen erkennen zu können. Der Empiriker lehnt die Vorwegnahme dieser Beziehungen ab und steht so im Gegensatz zum

Theoretiker, der von einem Bezugssystem ausgeht und sich in seinen Forschungen von den daraus abgeleiteten Implikationen führen läßt (Argument der Ökonomie!)

In der Diskrepanz zwischen beiden Einstellungen drückt sich nicht bloß eine unterschiedliche Bewertung der Theorie aus, sondern eine grundsätzliche Differenz in der Frage der methodischen Behandlung von Beobachtungsdaten:

Der Empiriker verfährt induktiv, d.h., er bewegt sich von den Fakten zur Formulierung von Gesetztesaussagen, die die Fakten beschreiben.

Der Theoretiker verfährt deduktiv, d.h., er geht von einem allgemeinen Grundsatz oder einer "dumpfen Ahnung" aus und sucht nach Evidenz, die den Grundsatz bekräftigen soll.

In der wissenschaftlichen Praxis, also in den meisten Fällen, sind Theorien das Ergebnis des Zusammenwirkens beider Methoden. Wissenschaftliche Theorien legen den Rahmen fest, in dem dann empirische Untersuchungen möglich sind. Ohne empirische Überprüfung bleibt der theoretische Rahmen ohne Inhalt, aber eine Untersuchung ohne Rahmen bleibt ebenso unverständlich.

Popper (1979) unterscheidet zwei Formen, empirische Forschung durchzuführen: mittels der Kübel- bzw. der Scheinwerfertheorie. Auf welche Art Wissenschaftler Daten erheben, ob mit Beobachtung, Experiment oder Befragung, in einem treffen sie auf Probleme allgemeiner Art, die instrumentunabhängig ist. Nach der Scheinwerfertheorie werden anfangs die informationshaltigen Hypothsen gebildet und erst nachher versucht, diese durch empirische Forschung bzw. Experimente auf ihren Wahrheitsgehalt zu prüfen, d.h., die Realität wird scheinwerferartig untersucht. Popper richtet seine Kritik hauptsächlich gegen die Kübeltheorie, in der empirischen Beobachtungen quasi wie in einem Kübel gesammelt werden, es also bloß um eine Anhäufung und Sammlung von Fakten geht, in der die Hypothesenbildung erst nach der Beobachtung erfolgt und von den Beobachtungsergebnissen abhängt. Karl Popper hat mit seiner Scheinwerfertheorie der Wissenschaft auf die Tatsache hingewiesen, dass nicht nur Laien für Vorurteile anfällig sind, sondern auch jede wissenschaftliche Beschreibung von Tatsachen selektiv ist: Was der Scheinwerfer sichtbar macht, das hängt von seiner Lage ab, von der Art und Weise, wie wir ihn einstellen, von seiner Intensität, Farbe und natürlich auch von der Entscheidung, was von ihm beleuchtet werden soll.

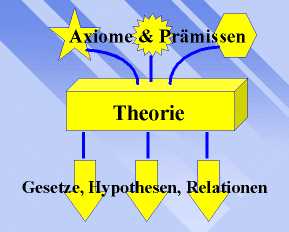

Die Funktion der Theorie ist es, die verfügbaren Tatsachenbefunde zu einem irgendwie strukturierten Ganzen zu verknüpfen. Dazu braucht sie (hypothetische) Konstrukte, (explikative und deskriptive) Hypothesen, (unabhängige, abhängige und intervenierende) Variablen und Gesetze.

Hypothetische Konstrukte

Prozesse, wie sie im Organismus, im Atom oder in der Galaxie stattfinden, sind der direkten Beobachtung nicht zugänglich. Was wir beobachten können, sind die Wirkungen dieser Prozesse. Die Kenntnis der Wirkungen als auch der Anstöße, durch welche sie ausgelöst werden, sowie das Bezugssystem einschlägiger Gesetze und Erkenntnisse ermöglichen Rückschlüsse auf das, was nicht sichtbar ist. Diese Konstrukte sind mit den übrigen Teilen der Theorie durch Hypothesen verbunden. Eine Hypothese ist ein - entweder aus theoretischen oder aus Faktenaussagen abgeleiteter - Schluß, der die Beziehungen zwischen beobachtbaren oder nicht beobachtbaren Größen, Prozessen oder Interaktionen betrifft. Eine Hypothese ist entweder explikativ (erklärend), d.h., sie trifft Voraussagen der Art, dass ein spezifisches Phänomen zusammen mit anderen Phänomenen als Begleiterscheinung auftreten wird, dass ein Kausalzusammenhang zwischen ihnen besteht, oder sie ist deskriptiv (beschreibend), d.h., sie sagt etwas über Phänomene aus, die sich mit einem spezifischen Phänomen auf gleichem Abstraktionsniveau befinden.

Popper (1979): "Observations are secondary to hypotheses".

Hypothetische Konstrukte haben einen eingeengteren Geltungsbereich als Hypothesen. Ihre Verwendung in Theorie und Forschung verhilft dem Konstrukt nach und nach zu einer genaueren Definition, seine Konnotationen und seine Abhängigkeit von anderen Faktoren treten deutlicher hervor. Diese Faktoren bezeichnet man auch als

Variablen

Variablen sind veränderliche Größen, die zur Beschreibung oder Erklärung von Phänomenen herangezogen werden können. Man unterscheidet weiter:

unabhängige Variablen: kausative Faktoren, die in einem Experiment manipuliert werden, um ihre Auswirkung auf abhängige Variablen zu beobachten, d.h., der Forscher stellt die Veränderungen in der Wirkung fest, um zu Schlüssen über den von ihm postulierten Prozeß zu gelangen. Sind die Elemente der Beziehung mit hinreichender Genauigkeit bestimmt, so kann er spezifische, exakte Voraussagen über Ereignisse und Verhaltensweisen machen. Er arbeitet jetzt mit intervenierenden Variablen: dabei handelt es sich um Prozesse, die sich relativ genau bestimmen lassen, obwohl sie selbst nicht beobachtet werden können. Es sind dies diejenigen Vorgänge, die man zur Erklärung eines Zusammenhanges zwischen den Veränderungen der beobachteten abhängigen Variablen und den Veränderungen der relevanten beobachtbaren unabhängigen Variablen annehmen muß. Diese intervenierenden Variablen sind eine Form von

wissenschaftlichen Gesetzen: Gesetze sind Ausdrücke für invariante Beziehungen jeglicher Art. Sie können sich auf den Zusammenhang zwischen zwei Ereignisse beziehen, oder aber sie sind so allgemein, dass sie sich auf Gruppen oder Klassen von Ereignissen erstrecken. (Sie haben einen engen oder weiten Geltungsbereich). Gesetze sind weiter gespannt als Konstrukte oder intervenierende Variablen, denn diese beschränken sich jeweils auf Vorgänge einer bestimmten Kategorie. Die Brauchbarkeit wissenschaftlicher Theorien hängt von der Klarheit und Exaktheit ihrer Sprache ab.

Die Sprache spielt eine wichtige Rolle, sobald sich eine Theorie anschickt, einen Begriff zu umreißen oder zu definieren. Alle Definitionen gehen von Elementarbegriffen aus, die keiner Definition bedürfen. Diese können wiederum abstrakt oder konkret sein. Der Empiriker definiert abstrakte Begriffe mittels konkreter Begriffe. Der Theoretiker macht die abstrakten zu seinen Elemantarbegriffen und definiert die konkreten Begriffe mittels der abstrakten Klassen, deren Elemente sie sind.

Die Praxis, abstrakte Begriffe durch Rückgriff auf konkretere Vorgänge zu definieren, hat vieles mit dem Verfahren der operationalen Definition gemeinsam. Der Operationalismus ist ein Hilfsmittel zur Definition und Eingrenzung der wissenschaftlich zulässigen Begriffe und Problemstellungen. Er garantiert dem Wissenschaftler nicht, dass seine Ergebnisse fehlerfrei oder dass seine Theorie valide sein werden. Ihre Bedeutung erhält die Operationalisierung aber in der Formulierung von Begriffen und die Ermöglichung von Kommunikation und Vergleichbarkeit zwischen wissenschaftlichen Systemen. Problematisch ist sie vor allem aber dann, wenn es zu einer Schwemme von solchen Definitionen für einen einzigen Terminus kommt, was in der Psychologie, der Erziehungswissenschaft und anderen Sozial- und/oder Humanwissenschaften nichts Seltenes ist. Während die bisher besprochene deskriptive Funktion der Theorie definitorische und Sprachprobleme aufwirft, führt ihre explikative Funktion zu Problemen logischer Natur. Die erste Schwierigkeit liegt in der Versuchung zum teleologischen Denken: grob gesprochen versteht man darunter, dass man einem zukünftigen Ereignis die Rolle der Ursache für irgendein aktuelles Verhalten zuschreibt, also die Ursache der Wirkung nachfolgen läßt . Wahrend diese logische "Fußangel" in den meisten Fällen leicht durchschaubar ist, sind anthropomorphe oder animistische Interpretationen weit verbreitet. Hier werden Analogien dazu mißbraucht, Zusammenhänge darzustellen, als ob sie sich tatsächlich so darstellen bzw. umschreiben lassen. Daher muß eine Analogie als solche immer kenntlich gemacht werden, denn ohne sie ist die Konstruktion einer Theorie natürlich unmöglich, die Erstellung eines Modells der Wirklichkeit gar nicht durchzuführen.

Unter einem Modell versteht man ein sorgsam konstruiertes System von Vorschlägen, Konstrukten, Analogien, Hyothesen, die gleichzeitig ein Ordnungsschema für diese anbieten. Modelle tragen ebenso wie Konstrukte den Charakter des Vorschlags und der Vermutung. Der Schöpfer eines Modells benutzt es bei seiner gesamten Forschung und modifiziert es solange, bis aus der ursprünglichen Metapher ein System von Gesetzesaussagen geworden ist. Der Nutzen solcher Modelle liegt darin, dass wir menschliches Verhalten so erklären können, als ob mechanische Prinzipien dabei mitspielten. Wesentlich bleibt aber, dass es sich eben nur um ein "als ob" handelt und nicht um die Realität selber.

Die Konventionen der Theoriekonstruktion sollen dem Wissenschaftler zu einem Bezugssystem von Gesetzen verhelfen, dessen er sich zur Entdeckung und Formulierung seiner Informationen bedienen kann. Wir unterscheiden Fundamentalgesetze, die Wahrheiten in invarianter und universaler Form aussagen. Sie gelten für alle Dinge innerhalb einer bestimmten Kategorie, sie sind in diesem Sinne unspezifisch. In den Sozial- und/oder Humanwissenschaften finden wir solche nicht, vielmehr sind die Aussagen statistische Gesetze, die aussagen, was unter welchen Umständen wahrscheinlich ist, was aber nicht unbedingt sein muß. Ihr Gegenstand ist eine Sache der mathematischen Wahrscheinlichkeit, nicht aber der absoluten Gewißheit. Alle Gesetze müssen Wahrheiten aussagen, gleichgültig, ob sie durch Beobachtung oder durch Schlußfolgerung gefunden wurden.

Ein letzter aber wesentlicher Punkt sind die praktischen Erfordernisse, die eine Theorie erfüllen muß:

Umfang der Theorie: eine Theorie muß ein weites Erscheinungsfeld umfassen und die einschlägigen (vorliegenden und zukünftigen) Daten ohne inneren Widerspruch verarbeiten können. Ökonomie der Theorie: diejenige Aussage ist die zweckmäßigste, die der wenigsten angenommenen Voraussetzungen bedarf, um sich in exakte Voraussagen transformieren zu lassen. Sie darf nicht umfangreicher sein als die Phänomene, die sie zu erklären versucht. Überprüfbarkeit der Theorie: sie muß anderen Wissenschaftlern die Möglichkeit geben, ihre Erkenntnisse nachzuvollziehen bzw. überprüfen zu können. Voraussagefahigkeit der Theorie: sie muß originell sein, also muß sie uns etwas sagen können, was wir ohne sie nicht ohnehin schon wissen; sie darf nicht bei einer Beschreibung stehen bleiben. Flexibilität der Theorie: sie kommt niemals zum Abschluß und muß neue Evidenzen verarbeiten können. Sie muß neue Informationen aufnehmen können, darf aber nicht gleichzeitig Verwendung für alle möglichen und unmöglichen Daten haben.

Die intersubjektive Überprüfbarkeit (Kommunikation) bedeutet, dass sowohl die empirischen Fakten einer intersubjektiven Überprüfung standhalten müssen als auch die Schlußfolgerungen im Rahmen einer Theorie. "Intersubjektiv" hat damit eine mehrfache Bedeutung:

- für prinzipiell alle Menschen beobachtbar,

- prinzipiell wiederholbar und alle

- Schlußfolgerungen müssen für andere nachvollziehbar sein, also gewissen logischen Regeln des Argumentierens gehorchen.

Beispiel: Es gibt zahlreiche Berichte über Ufos. Es handelt sich, wenn wir die Zeugen als glaubwürdig einstufen, um "Beobachtungen", insofern auch um "Tatsachen". Es gibt auch eine Theorie: Ufos seien extraterrestrische Maschinen zum intergalaktischen Verkehr. Für viele Ufo-Anhänger wird diese Theorie durch ihre individuelle Beobachtung bestätigt. Es ist aber bislang nicht gelungen, die Beobachtungen intersubjektiv zu bestätigen; die Beobachtungen sind einseitig (nur sichtbare Phänomene, es fehlen überprüfbare Wirkungen: außerirdische Gegenstände usw.). Auch ist die zugehörige Theorie keineswegs die einzig mögliche. Es gibt auch psychologische Theorien über Ufos (Wahrnehmungsstörungen, Halluzinationen, Projektionen des kollektiven Unbewußten usw.). Ähnliches gilt für viele Phänomene der Psi-Forschung.

Einwände gegen Poppers Kritischen Rationalismus

Thies (2004) weist in Form von drei Thesen darauf hin, dass alle Einwände, die man gegen Popper formulieren kann, von ihm selber schon bedacht worden sind, wobei er seine Konzeption selber weiterentwickelt hat. "Poppers Kritischer Rationalismus richtet sich in erster Linie gegen empiristische Konzepte, vor allem gegen den Logischen Empirismus des Wiener Kreises (Carnap, Neurath, Schlick u.a.). Carnap sah sich daraufhin zu einigen Revisionen gezwungen, etwa der Präzisierung seiner Vorstellungen von einer induktiven Logik. Popper bleibt mit seiner Empirismus-Kritik aber im Recht: Es gibt kein "unschuldiges Auge“, jede Beobachtung ist theoriebeladen, in jedem Begriff stecken schon theoretische Annahmen. Popper hat später dafür folgendes Bild geprägt: Die menschliche Erkenntnis gleicht nicht einem Kübel, sondern einem Scheinwerfer (in "Objektive Erkenntnis“, Hamburg 1998, 61ff., 354ff.). Deshalb werden Theorien nicht aus der Erfahrung abgeleitet (das geschieht bestenfalls im "context of discovery“). Allerdings bleibt Erfahrung die Kontrollinstanz, die Falsifikationen herbeiführen kann; die kritische Prüfung von Theorien (im "context of justification“) erfolgt empirisch. Generell ist gegen Popper einzuwenden, dass sein Bild der Wissenschaften zu "idealistisch“ ist. Insbesondere darf man sich Falsifikationen nicht zu einfach vorstellen.

- Von Duhem kann man lernen, dass immer mehrere Theorien netz-artig miteinander verbunden sind (Holismus). Auch Popper spricht von einem "empirisch-wissenschaftlichen System“. Wenn eine Beobachtung negativ ausfällt, bleibt immer noch die Frage, welcher Teil des ganzen Ensembles aufgegeben werden soll.

- Ein einziger schwarzer Schwan widerlegt nicht die ganze "Schwäne-sind-weiß“-Theorie. Es sind immer Erklärungen möglich, wie es zu dieser negativen Beobachtung kommen kann: eine einmalige genetische Mutation, eine absonderliche Krankheit o.ä. Nicht jeder missglückte Versuch im Physikunterricht bringt die moderne Wissenschaft zum Einsturz. Offensichtlich muss über die Annahme oder Ablehnung eines falsifizierenden Basissätze noch entschieden werden.

- Dabei spielt eine Rolle, ob bereits eine andere Theorie zur Verfügung steht, die auftauchende "Anomalien“ und alle bisherigen Beobachtungen besser erklären kann. Man muss die Konkurrenz verschiedener Theorien stärker berücksichtigen.

Popper gesteht zu, dass er Voraussetzungen macht, die er nicht begründen kann. Der Kritische Rationalismus beruhe, so folgert er mit Konsequenz, auf einer "moralische(n) Entscheidung“ ("Die offene Gesellschaft und ihre Feinde“, Bd. 2, 24. Kap., Tübingen 71992, S. 271 u. 281). Wenn Popper also behauptet, dass Wissenschaft nach Wahrheit suchen sollte (Wahrheit als regulative Idee), sich dieWahrheit einer Aussage aber niemals ausweisen lasse, so vermag Popper nicht zu begründen, warum Wissenschaft nach

Wahrheit suchen sollte (Selbstanwendungsargument). Gemäß seinen eigenen Voraussetzungen kann Poppers Idee von Wissenschaft bloß empirisch besser bewährt sein als eine andere – das ist aber, wie von Kuhn und Feyerabend gezeigt wurde, keineswegs der Fall." Thies sieht als einzigen Ausweg eine transzendentale Erweiterung des Kritischen Rationalismus etwa in dem Sinne: "Wahrheit ist nicht bloß die regulative Idee wissenschaftlichen Handelns, sondern auch eine unausweichliche Voraussetzung. Zudem gehen in die Wissenschaften weitere apriorische Annahmen ein, deren Geltung man begründen kann."

Expertise vs Statistik

Die empirische Forschung zur prognostischen Validität zeigt, dass eine allein auf statistischen Modellen gestützte Prognose im Durchschnitt besser ist als das Expertenurteil. Ich machs mal ganz einfach. Statistiker haben herausfinden, dass die Merkmale A, B und C stark mit dem Verhalten X zusammenhängen. Nun nehmen wir hundert Experten, die Vorhersagen sollen, ob hundert Probanden das Verhalten X zeigen werden. Unabhängig davon messen wir die Merkmale A, B und C und prognostizieren auf Basis eines mathematischen Modells das Verhalten X. Die Wahrscheinlichkeit, dass die Vorhersage auf Grundlage des mathematischen Modells zutrifft, ist deutlich höher als die Wahrscheinlichkeit, dass die Experten richtig liegen. Dies zeigen fünfzig Jahre empirische Forschung zur Validität von Expertenurteilen. Es zeigte sich zum Beispiel, dass der Berufserfolg von Auszubildenden sogar allein mit einem popeligen Intelligenztest besser vorhergesagt wird als durch das Urteil erfahrenener Personaler.

Es zeigte sich zum Beispiel, dass die Kombination von Persönlichkeitstests mit ein paar soziodemographischen Merkmalen die Rückfallgefahr von Straftätern besser vorhersagt als das Urteil erfahrener forensischer Psychiater. Man könnte die Liste beliebig fortsetzen, es ist immer so. Die prognostische Validität wird immer erhöht, wenn man psychologische Instrumente wie Tests, Fragebögen, Assessment Centers einsetzt und die Werte mit soziodemographischen Variablen durch geeignete mathematische Modelle miteinander in Beziehung setzt. Es ist also keineswegs so (…), dass die Statistiker die grobe Orientierung liefern und die Experten dann die Feinabstimmung zu leisten hätten. Durch diese "Feinabstimmung" verschlechtern sie sogar häufig die Prognosegüte. Das ist ein Fakt.

Menschen überschätzen ihre Urteilsfähigkeit meist erheblich. Psychologen und andere Psycho-Experten müssten das eigentlich wissen, weil die entsprechenden Studien nicht geheimgehalten werden. Man kann sie in jeder Universitätsbibliothek ausleihen. Nun habe ich die Vermutung, dass für diese selbstwerterhaltende Missachtung der Wirklichkeit neben ökonomischen auch psychologische Gründe verantwortlich sein könnten. In der Psychopathologie nennt man Wirklichkeitsverzerrungen zum Zwecke der Selbstwertregulation Narzissmus. Eine weitere charakteristische Neigung von Narzissten ist die Entwertung von Leuten, die das eigene, pathologisch überhöhte Selbstwertgefühl in Frage stellen. Was das in der Praxis bedeuten kann, konnte man vor einigen Jahren staunend beobachten, als der Wissenschaftsjournalist Rolf Degen sein Buch über die "Psychoirrtümer" herausbrachte. In diesem Buch behauptete er, dass Psychotherapien im Grunde Placebotherapien seien. Er behauptete damit für den Fachmann nichts Neues. Ähnliches hatte beispielsweise Robyn Dawes in seinem Buch House of Cards schon vorher publiziert. Eine methodenkritische Auswertung der bisherigen empirischen Psychotherapieforschung lässt auch keinen anderen Schluss zu. Dawes und Degen sind keine Spinner, sie wenden nur die Methoden an, die sie als Psychologen gelernt haben und die in Fachkreisen allgemein auch als verbindlich gelten. Degen schlug eine Wut aus Psychotherapeutenkreisen entgegen, die mit Worten kaum noch zu beschreiben ist. Auch Dawes musste einiges einstecken, aber die Amerikaner sind offenbar nicht ganz so irrational wie die Deutschen. Diese geifernden Angriffe lassen sich m. E. mit wirtschaftlichen Interessen allein nicht erklären. Hier dürften auch psychologische Gründe eine Rolle spielen. Schmidbauers Theorie des Helfersyndroms als einer Form der Narzisstischen Persönlichkeitsstörung scheint mir zur Erklärung durchaus geeignet zu sein. (…)

Auf diese Ausführungen antwortete Wolfram Heinrich:

Der MPU-Gutachter oder auch ein forensischer oder anderer psychologischer Gutachter soll aber nicht das Verhalten von hundert Probanden voraussagen, sondern von einem. Die statistischen Erkenntnisse über die Personengruppe, welcher der Proband angehört, sind dabei eine wichtige Information, sie

reichen aber - logischerweise - nicht aus. Ich muß ja mein Wissen über die Gesamtheit und meine Erkenntnisse über diesen einen speziellen Menschen zusammenbringen. Dabei muß mich die Statistik im Stich lassen, weil ihr das nicht mehr zugänglich sein *kann*.

Es geht (…) um einen speziellen Menschen. Und um dein Beispiel von oben aufzugreifen: Mein Job als Gutachter ist es, herauszufinden, wieweit die Merkmale A, B und C bei Herrn

N. ausgeprägt sind, um dann sein künftiges Verhalten X vorauszusagen. (…)

Quelle: Heinrich Drendorf und Wolfram Heinrich in der Newsgroups "de.sci.psychologie" (Sun, 6 Aug 2006 11:32:12)

Hervorhebungen und Kürzungen (…) von mir; W.S.

Wie kann man auf Grund empirischer Daten auf den Einzelfall schließen?

Natürlich kann man von einer Stichprobe nicht auf den Einzelfall schließen, was "Nomologen" nicht behauptent. Es hat sich aber generell gezeigt, dass für psychologische Entscheidungen Prognosen auf der Basis mathematischer Modelle (z.B. Regressionsgleichungen) valider sind als "klinische", "naive" oder heuristische Vorhersagen. Geschlossen wird also nicht von einer Stichprobe auf den Einzelfall, sondern von einer Stichprobe, an der die Validität und Reliabilität von Messverfahren getestet wurde, auf andere Stichproben. Die gilt im übrigen für alle psychologischen Tests. Sie bewähren sich nicht für den Einzelfall, für das Individuum, sondern für das Kollektiv. Wird beispielsweise mit Tests oder Assessment Centers die Eignung für bestimmte Arbeitsstellen diagnostiziert, so profitiert davon bei einer größeren Zahl von Bewerbern und Stellen systematisch nur das Unternehmen, wohingegen leider manche Bewerber, die durchaus geeignet wären, abgelehnt und andere, die nicht geeignet sind, angenommen werden. Der Nutzen zeigt sich nur im Durchschnitt, nicht im Einzelfall. Wenn man also in einer repräsentativen Stichprobe feststellt, dass 95% Menschen mit dem Merkmalsmuster X für eine Stelle geeignet sind, dann heißt das nicht für Herrn Meyer, der dieses Merkmalsmuster hat, dass er mit 95%iger Wahrscheinlichkeit für die Stelle geeignet ist. Es heißt nur, dass ich bei einer weiteren Ziehung einer Stichprobe aus derselben Grundgesamtheit wieder für das Merkmalsmuster X eine 95%ige Wahrscheinlichkeit der Eignung erwarten kann (Erwartungswert). Und dann und nur dann, wenn mich in erster Linie meine Entscheidungen für Aggregate optimieren möchte, wenn ich im Schnitt die größtmögliche Zahl von Geeigneten einstellen möchte, darf ich derartige Statistiken benutzen.

Ist diese Voraussetzung erfüllt, dann sind mathematische Modelle leistungsfähiger als einzelfallorientierte Methoden. Auch das müsste einleuchten. Über die Wahrscheinlichkeit, mit der Herr Meyer für die Stelle geeignet ist, wissen wir, obwohl Merkmalsträger, überhaupt nichts aufgrund seiner Merkmalsträgerschaft. Wir wissen nur: Wenn wir nur Menschen mit der Merkmalskombination X einstellen, dann dürfen wir erwarten, dass (eine hinlängliche große Zahl von Einstellungen vorausgesetzt) 95 Prozent dieser Menschen für die Stelle geeignet sind.

Dieses Phänomen kann man übrigens nicht nur im psychologischen Bereich beobachten, sondern einfach überall, z. B. bei der stochastischen Bedarfsermittlung in der Materialwirtschaft im Vergleich zur "Pi-mal Daumen-Methode" (um nur eine Anwendung willkürlich herauszugreifen).

Gekürzter Beitrag von Ulrich Gresch in der Newsgroups "de.sci.psychologie" 13.11.2007 18:52 Uhr) Kürzungen und Umformulierungen von mir; W.S.

Anmerkung: Diese Darstellung entspricht einem auch heute noch dominierenden empiristisch-nomologisch-naturwissenschaftlichen Wissenschaftsverständnis, das aber in den letzten Jahren von einigen Wissenschaftlern (insbesondere Wissenchaftstheoretikern) aus verschiedenen Gründen in Frage gestellt wird. Insbesondere das Problem der Wahrheit, der Induktion und Deduktion, der Kausalität, der wissenschaftlichen Sprache und Gesetze wurden kritisch durchleuchtet.

Tipp: Empfehlenswert für PsychologInnen sind im Internet zugängliche Skripten von Uwe Mortensen (Emeritus der Westfälischen Wilhelms Universität), der auf seiner Homepage (http://www.uwe-mortensen.de/) grundlegende Texte zur Wissenschaftstheorie als pdf-Dateien anbietet:

- I Überblick und Anfänge

- II Der Beginn der experimentellen Wissenschaft

- III Wissenschaft zwischen Positivismus und Hermeneutik

- IV Intentionalität, Kausalität, und das Problem der Modellierbarkeit kognitiver Prozesse

Alle Sktipten werden dankenswerter Weise immer wieder korrigiert und erweitert. Daneben finden sich weitere Perlen des Internet zur Testtheorie und Testkonstruktion, zur Statistik und zur Wahrscheinlichkeitstheorie, ebenfalls als pdf-Dateien downloadbar. Auch wenn die Begründungen und Ableitungen mathematische und statistische Kenntnisse erfordern, sind die Methoden und deren Bedeutung und Zielsetzungen im Rahmen der wissenschaftlichen Psychologie in einer anschaulichen und leicht verständlichen Sprache abgefasst, in der man den engagierten Lehrenden erkennen kann.

Inhaltsübersicht Forschungsmethoden der Psychologie und Pädagogik

- Grundbegriffe des Empirismus

- Grundlagen empirischer Sozialforschung

- Messung als Modellbildung

- Gütekriterien für Wissenschaft und wissenschaftliche Forschungsarbeiten

- Gütekriterien empirischer Forschung

- Gütekriterien qualitativer Forschung

- Forschungsplanung

- Detailschema für die Projektierung einer empirische Untersuchung

- Die Beobachtung

- Das Experiment

- Der psychologische Test

- Soziometrie

- Inhaltsanalyse

- Der Fragebogen

- Das Interview

- Das standardisierte Interview

- Narratives Interview

- Die Gruppendiskussion

- Stichproben

- Einzelfallforschung

- Handlungsforschung

- Was ist Kausalität?

Werner Stangl: Test und Experiment in der Psychologie

Werner Stangl: Test und Experiment in der Psychologie

- Literatur und Quellen